13 KiB

Интерфейс перевода больших моделей

Универсальный интерфейс для больших моделей

::: details Использование нескольких интерфейсов больших моделей одновременно? Если вам нужно просто чередовать несколько разных ключей API, достаточно разделить их символом |.

Но иногда требуется одновременно использовать разные API-адреса/prompt/модели/параметры для сравнения результатов перевода. Метод следующий:

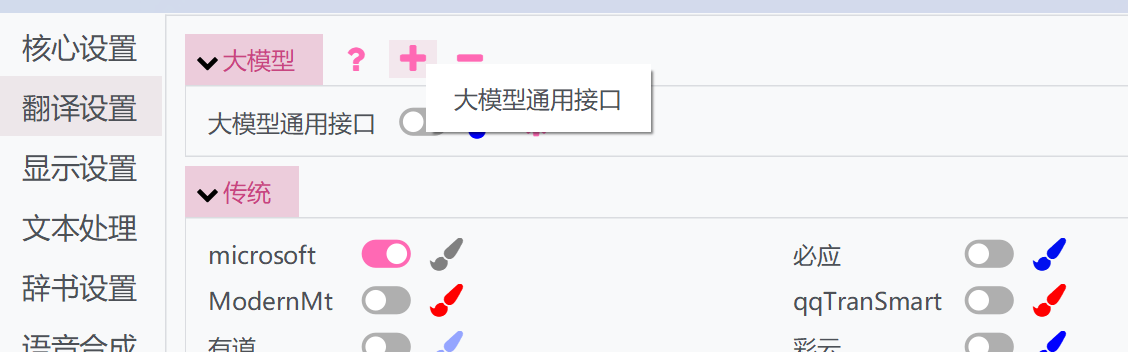

- Нажмите кнопку «+» выше и выберите универсальный интерфейс большой модели

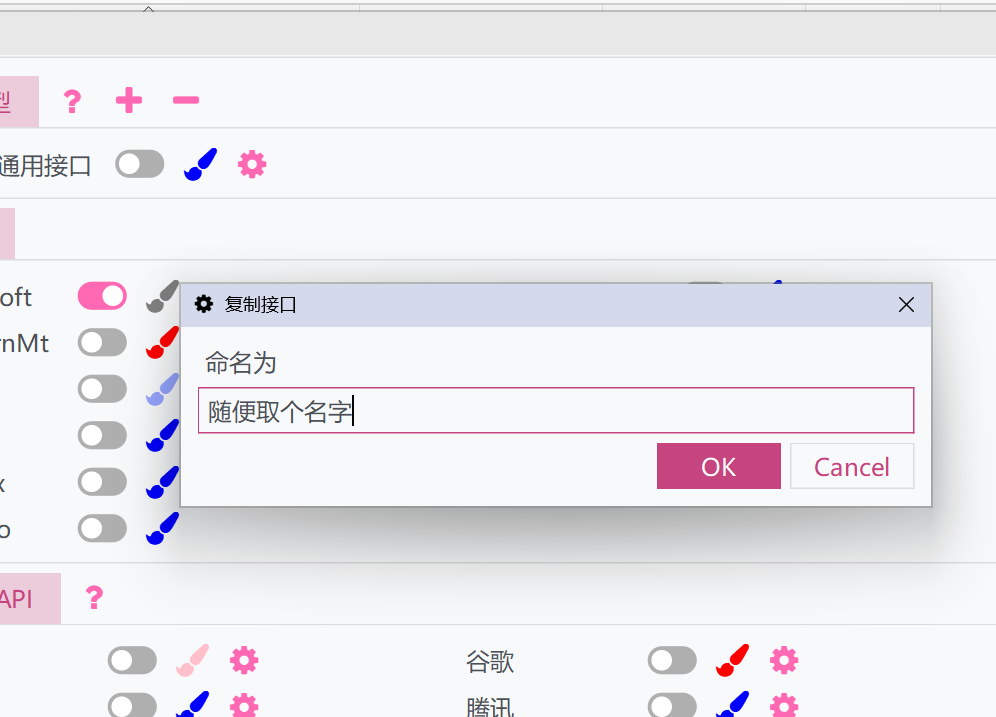

- Появится всплывающее окно — дайте ему имя. Это позволит дублировать текущие настройки и API универсального интерфейса большой модели

- Активируйте скопированный интерфейс и настройте его отдельно. Скопированный интерфейс может работать параллельно с оригинальным, позволяя использовать разные настройки.

:::

:::

Описание параметров

-

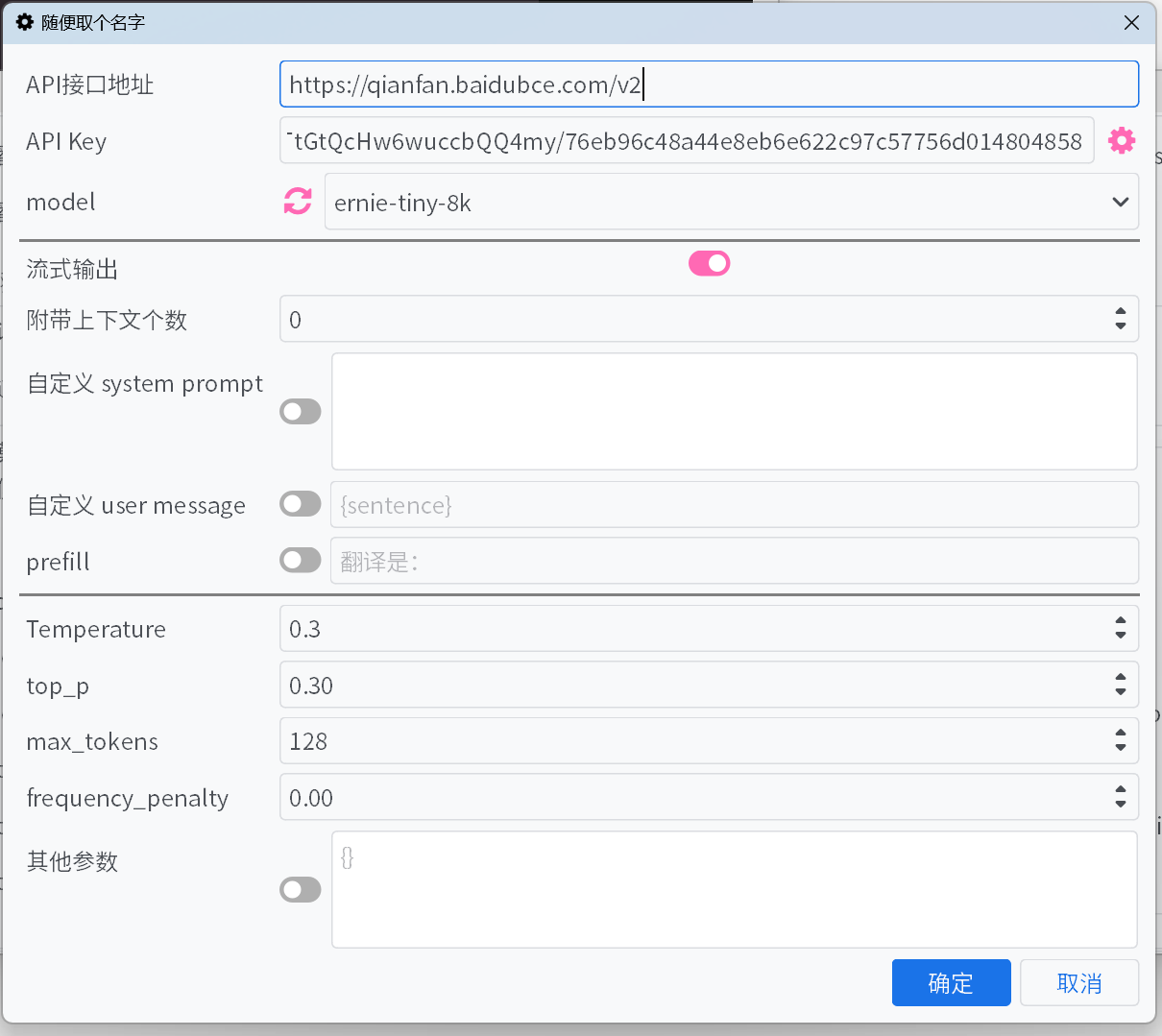

Адрес API-интерфейса

Большинство

адресов API-интерфейсовраспространённых платформ больших моделей можно выбрать из выпадающего списка, но некоторые могут отсутствовать. Для интерфейсов, которые не указаны в списке, пожалуйста, укажите их вручную, ознакомившись с документацией платформы. -

API Key

API Keyможно получить на платформе. Если добавлено несколько ключей, система автоматически будет перебирать их по очереди и корректировать их приоритет на основе ошибок. -

model

Для большинства платформ после заполнения

адреса API-интерфейсаиAPI Keyможно нажать кнопку обновления рядом с полемmodel, чтобы получить список доступных моделей.Если платформа не поддерживает автоматическое получение списка моделей, а нужная модель отсутствует в списке по умолчанию, укажите её вручную, следуя официальной документации API.

-

Потоковый вывод

При включении содержимое будет выводиться постепенно, по мере генерации модели. В противном случае весь текст отобразится только после завершения генерации.

-

Скрывать процесс размышления

При включении содержимое, заключённое в теги <think>, отображаться не будет. Если скрытие процесса размышления активно, будет показываться текущий прогресс.

-

Количество прикрепляемого контекста

Система будет прикреплять указанное количество предыдущих исходных текстов и переводов к запросу для улучшения качества перевода. Если установлено значение 0, эта функция отключается.

- Оптимизация кэширования — для таких платформ, как DeepSeek, запросы с попаданием в кэш тарифицируются по сниженной цене. Активация этой функции оптимизирует формат прикрепляемого контекста для увеличения вероятности попадания в кэш.

-

Пользовательский system prompt / Пользовательское user message / prefill

Различные способы управления выводом модели. Можно настроить по своему усмотрению или оставить значения по умолчанию.

В пользовательских системных подсказках и сообщениях можно использовать поля для ссылок на некоторую информацию:

{sentence}: Текущий текст для перевода{srclang}и{tgtlang}: Исходный язык и целевой язык. Если в подсказке используется только английский язык, они будут заменены на английский перевод названий языков. В противном случае они будут заменены на перевод названий языков на текущем языке интерфейса.{contextOriginal[N]}и{contextTranslation[N]}и{contextTranslation[N]}: N элементов исторического текста, перевода и обоих. N не связано с «количеством сопроводительных контекстов» и должно быть заменено на целое число при вводе.{DictWithPrompt[XXXXX]}: Это поле может ссылаться на записи из списка «Перевод собственных имен». Если совпадающая запись не найдена, это поле будет очищено, чтобы не нарушать содержание перевода. ЗдесьXXXXX— это промпт, который направляет LLM на использование данных записей для оптимизации перевода. Его можно настроить или отключить пользовательские сообщения для использования промпта по умолчанию.

-

Temperature / max tokens / top p / frequency penalty

Для некоторых моделей на некоторых платформах параметры, такие как

top pиfrequency penalty, могут не поддерживаться интерфейсом, или параметрmax tokensможет быть устаревшим и заменен наmax completion tokens. Активирование или деактивирование переключателя может решить эти проблемы. -

reasoning effort

Для платформы Gemini параметр автоматически преобразуется в

thinkingBudgetпо следующим правилам:минимальный -> 0 (отключение мышления, но не применимо к модели Gemini-2.5-Pro), низкий -> 512, средний -> -1 (включение динамического мышления), высокий -> 24576.

-

Другие параметры

Выше перечислены только основные параметры. Если платформа поддерживает другие полезные параметры, их можно добавить вручную в формате «ключ-значение».

Популярные платформы больших моделей

Крупномасштабные платформы моделей в Европе и Америке

::: tabs

== OpenAI

API Key https://platform.openai.com/api-keys

== Gemini

API Key https://aistudio.google.com/app/apikey

== claude

API Key https://console.anthropic.com/

model https://docs.anthropic.com/en/docs/about-claude/models

== cohere

API Key https://dashboard.cohere.com/api-keys

== x.ai

API Key https://console.x.ai/

== groq

API Key https://console.groq.com/keys

== OpenRouter

API Key https://openrouter.ai/settings/keys

== Mistral AI

API Key https://console.mistral.ai/api-keys/

== Azure

API-адрес https://{endpoint}.openai.azure.com/openai/deployments/{deployName}/chat/completions?api-version=2023-12-01-preview

Замените {endpoint} и {deployName} на ваши значения endpoint и deployName

== deepinfra

API Key https://deepinfra.com/dash/api_keys

== cerebras

API Key https://cloud.cerebras.ai/ -> API Keys

== Chutes

API Key https://chutes.ai/app/api

:::

Крупномасштабные платформы моделей в Китае

::: tabs

== DeepSeek

API Key https://platform.deepseek.com/api_keys

== Alibaba Cloud Bailian

API Key https://bailian.console.aliyun.com/?apiKey=1#/api-key

model https://help.aliyun.com/zh/model-studio/getting-started/models

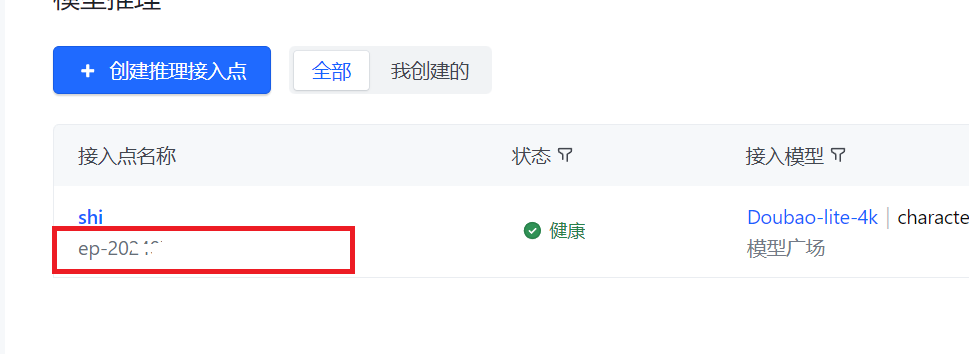

== ByteDance Volcano Engine

API Key Получите создав API Key

model После создания точки доступа для вывода введите точку доступа, а не модель

== Moon's Dark Side

API Key https://platform.moonshot.cn/console/api-keys

== Zhipu AI

API Key https://bigmodel.cn/usercenter/apikeys

== 01.AI

API Key https://platform.lingyiwanwu.com/apikeys

== SiliconFlow

API Key https://cloud-hk.siliconflow.cn/account/ak

== iFlytek Spark Large Model

API Key Ссылаясь на официальную документацию, получите APIKey и APISecret, затем введите в формате APIKey:APISecret

== Tencent Hunyuan Large Model

API Key См. официальную документацию

model https://cloud.tencent.com/document/product/1729/97731

== Baidu Qianfan LLM

API Key https://cloud.baidu.com/doc/WENXINWORKSHOP/s/Um2wxbaps

model https://cloud.baidu.com/doc/WENXINWORKSHOP/s/Fm2vrveyu

Warning

API Key Для заполнения API Key используйте Access Key и Secret Key из Baidu Intelligent Cloud IAM для генерации BearerToken интерфейса, либо введите их напрямую в API Key в формате

Access Key:Secret Key. Обратите внимание, что это не API Key и Secret Key устаревшей версии v1 интерфейса Qianfan ModelBuilder - они не взаимозаменяемы.

== MiniMax

API Key https://platform.minimaxi.com/document/Fast%20access?key=66701cf51d57f38758d581b2

:::

Менеджер агрегации API

Также можно использовать инструменты ретрансляции API, такие как new-api, для более удобного агрегирования и управления множеством моделей платформ больших моделей и несколькими ключами.

Способ использования можно посмотреть в этой статье.

Модель офлайн-развертывания

Также можно использовать такие инструменты как llama.cpp, ollama для развертывания модели, после чего ввести адрес и модель.